Sensor översätter text till tal

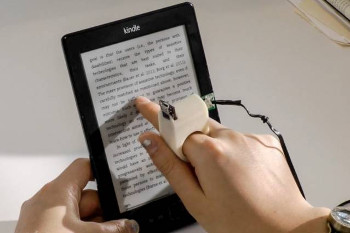

Forskare vid MIT Media Laboratory har byggt en prototypsensor med inbyggd kamera som träs på fingret och används till att omvandla text till syntetiskt tal för synskadade användare.

Den nya sensorenheten ger återkoppling – antingen i taktil eller hörbar form – som vägleder användarens finger längs en textrad, och genererar därpå motsvarande tal i realtid.

– Du måste verkligen ha en tät koppling mellan vad personen hör och var fingertoppen är, säger Roy Shilkrot, en MIT-doktorand i media arts och vetenskap som tillsammans med Media Lab postdoc Jochen Huber skrivit ett papper som beskriver enheten. För synskadade användare är detta en översättare. Det är något som översätter vad fingret "ser" till ljud.

I papperet redovisas också resultaten från en studie i användbarhet som genomförts med synskadade volontärer där forskarna testade flera varianter av sin enhet. En inkluderade två haptiska motorer, en på toppen av fingret och den andra under den. Vibrationen från motorerna indikerar om personen bör höja eller sänka spårningsfingret. En annan version, utan motorer, använde i stället ljudåterkoppling med en ton som ökar i volym om användarens finger började att glida bort från textraden. Forskarna testade även motorerna och ljudtonen tillsammans. Det fanns dock ingen konsensus om vilken typ av respons som var mest användbar så i det pågående arbetet koncentrerar sig forskarna på ljudåterkoppling eftersom det gör sensorn en mindre och lättare.

Nyckeln till systemets realtidsprestanda är en algoritm för bearbetning av kamerans videoåtergivning, vilken Shilkrot och hans kollegor utvecklat. Varje gång användaren placerar sitt finger i början av en ny textrad gör algoritmen en mängd gissningar om bokstävernas baslinje. Eftersom de flesta textrader har bokstäver vars bottnar sjunker under baslinjen och eftersom skeva inriktningar av fingret kan leda till att systemet blir förvirrat av närliggande rader kommer dessa gissningar skilja sig åt. Men de flesta av gissningarna tenderar dock att samlas ihop och algoritmen väljer medianvärdet av det tätaste klustret.

Detta värde, i sin tur, begränsar de gissningar som systemet gör för varje ny bildruta då användarens finger rör sig åt höger. Något som minskar algoritmens beräkningsbörda.

När man har en uppskattning av textens baslinje spårar algoritmen också varje enskilt ord när detta glider förbi kameran. När den känner av att ett ord är placerat nära centrum av kamerans synfält – vilket reducerar distorsionen – skärs just det ordet ut ur bilden. Den uppskattade baslinjen tillåter också algoritmen att justera ordet och kompensera för förvrängning som orsakas av udda kameravinklar innan en mjukvara känner igen bokstäverna och omvandlar ord den känner igen till syntetiskt tal. Algoritmerna exekverades på en bärbar dator ansluten till de fingermonterade enheterna och en programvara för Android-telefoner håller på att utvecklas av andra forskare vid MIT:s Undergraduate Research Opportunities Program.

Forskarna har också upptäckt att deras enhet kan ha ett bredare användningsområde än de ursprungligen insett.

– Sedan vi började arbeta med detta stod det klart för oss att alla som behöver hjälp med att läsa kan dra nytta av den, säger Shilkrot. Vi har fått många mail och förfrågningar från organisationer men också från föräldrar till barn med dyslexi.

– Det är en bra idé att använda fingret som ersättning för ögonrörelser eftersom fingrarna, liksom ögat, snabbt kan röra sig i x och y-led och skanna saker snabbt, säger George Stetten, läkare och ingenjör med gemensamma utnämningar på Carnegie Mellon s Robotics Institute och University of Pittsburghs Bioengineering Department, som utvecklar en fingermonterad enhet som ger synskadade användare information om avlägsna objekt. Jag är mycket imponerad av vad de gör.

Filed under: Utländsk Teknik