Energioptimering och IP på DAC 2012

Låg energiförbrukning var det genomgående temat för nästan allt på årets Design Automation Conference. Det är en förutsättning för alla de nya portabla tillämpningar som utvecklas och en förutsättning för nästan alla nya byggsätt och minskade geometrier. Och utvecklingen går verkligen snabbt framåt.

Det var tre år sedan jag senast besökte Design Automation Conference, men de tjugo åren innan dess missade jag sällan en DAC. Därför var det extra intressant att se hur utvecklingen gått, både de senaste åren och under hela tiden från nittiotalet och framåt.

Och visst är det stor skillnad på årets DAC-konferens och konferenserna på nittiotalet och början av tjugohundratalet. För inte så hiskeligt många år sedan tvivlade man på att framtida DAC-konferenser skulle få plats i San Fransiscos Moscone Center. I dag räcker det med en bit av den södra delen. Och för inte så länge sedan var pressrummet fullt av journalister från alla delar av Europa. I år var ytterst få länder utanför USA representerade med egna journalister.

Fantastiskt bra

Men det här skall definitivt inte handla om att det var bättre förr, för det var det inte. EDA-industrin har mognat, vinsterna har minskat och i den processen har media i mångt och mycket tappat intresset. Men teknikutvecklingen är fortsatt otrolig och vi talar faktiskt om en industri som växer på ett riktigt hyfsat sätt.

Om vi lyfter blicken lite och tittar på vad som hänt på sådär ett tjugotal års sikt är det lätt att imponeras. I och för sig tar det alltid längre tid för nya tekniker att etableras än vad föregångarna tror, men i det här fallet handlar det om en industri där föregångarna alltid målar upp fullständigt otroliga visioner. Det märkliga är att visionerna trots allt brukar slå in, även om det tar ett par år extra.

Så allt det som förutspåddes om IP-block och IP-användning i mitten av nittiotalet är verklighet idag. Det mesta av det man trodde om högnivåsyntes och högnivåverifiering är också verklighet. Teknikutvecklingen följer Moores Lag och verktygsutvecklingen har på något märkligt sätt hela tiden lyckats hålla jämna steg. Det är fantastiskt.

USB blev laddstandard

Men låt oss börja med energiförbrukningen. En av de allra största trenderna de senaste tjugo åren är att allt har blivit bärbart och batteridrivet. Samtidigt har prestandakraven ökat dramatiskt, utan att batterierna blivit särskilt mycket bättre. Vem som helst kan inse att det här inte fungerar.

Ett av de mest synliga problemen är uppsjön av batteriladdare. De flesta har säkert lådor fulla av batteriladdare och få saker genererar väl så mycket svordomar som borttappade laddare och urladdade batterier. Redan härvan av sladdar och batteriladdare på skrivbordet i mitt hotellrum räckte utmärkt väl för mig. Då hade jag ändå inte fått med mig laddaren till kameran.

Så här ser (i bästa fall) en ordinär härva av laddare ut.

Att min härva ändå blir ganska prydlig beror på att jag för många år sedan ”konstruerade” en ganska reglementsvidrig adapter mellan USA-standard och Europa-standard. Den gör att jag kan ha upp till fem olika prylar enligt svensk standard anslutna till ett enda USA-uttag och den har hjälpt mig många gånger. Förutsättningen är förstås att laddarna klarar 110 V, men det är sällan ett problem nuförtiden.

Nu börjar tack och lov allt fler elektriska apparater använda USB-anslutningen för laddning. Det är i och för sig vansinnigt. USB-standarden var aldrig tänkt att användas på det sättet och klarar därför bara ett par W. Men tillverkarna har inte mycket att välja på och det är en av de faktorer som hårdast driver utvecklingen mot låg strömförbrukning. Det hjälper ju inte att stoppa in ett stort batteri om det tar löjligt lång tid att ladda upp det.

Energioptimering

Men tillbaka till San Fransisco och Design Automation Conference. Kraven på ökade prestanda och längre batteritid ger bara två utvägar. En av dem är stängd – batteriutvecklingen är långsam och laddströmmen är begränsad. Därför återstår i praktiken bara en. Konstruktionerna måste göras så energisnåla som det bara är möjligt.

Alla talar alltså om energioptimering på alla nivåer. Dagens halvledarkonstruktioner har massor av ”effektdomäner” som blir allt mer knepiga både att konstruera och verifiera. Skall man dessutom komma riktigt långt gäller det att kunna mata in kraven redan från början och göra ”what-if”-analys direkt.

Det här är i och för sig inget nytt. Redan för flera år sedan började det komma energioptimeringsverktyg i större skala. Skillnaden är att man idag verkar betrakta energiförbrukningen som viktigare än både timing och kiselarea. Allt hänger förstås ihop, men man väljer allt oftare att börja med energiförbrukningen och låta resten bli bisaker.

En kul detalj är att diskussionen om tredimensionella byggsätt på komponentnivå (3D-IC och 2,5D-IC) fungerar som ytterligare en stark pådrivare när det gäller att minska energiförbrukningen. De flesta är överens om att tredimensionella byggsätt kommer att ta över allt mer, till och med inom lågpris konsumentprodukter. De flesta verkar också överens om att lösningen på kylproblemet är att minska energiförbrukningen per chip ännu mer. Det finns visserligen avancerade lösningar med vätskekylning etc, men i praktiken blir det alldeles för dyrt. Huvudspåret är att optimera och minska energiförbrukningen.

Chokladkaka

Det här märktes också på några av de bästa keynote-föredragen. I särklass bäst var nog Mike Muller från ARM, som visade hur konstruktionsarbetet hade förändrats från den allra första ARM-processorn i mitten av åttiotalet fram till idag. Han gjorde en verkligt intressant jämförelse mellan konstruktionen av den tidens ARM-1 och dagens CortexM0. Den visade hur halvledarkonstruktörerna och EDA-tillverkarna faktiskt lyckats att hänga med Gordon Moores gamla förutsägelser från åttiotalet. 3 µm har blivit 20 nm och varje ”oöverstigligt” gap har kunnat överbryggas. Mike Mullers tal förklarade också varför ARM lyckats så bra. De var smarta nog att ta tag i energiförbrukningsproblemet redan från början. Eller så kanske de hade turen att göra rätt.

Mike Muller från ARM visade hur konstruktionsarbetet hade förändrats från den allra första ARM-processorn i mitten av åttiotalet fram till idag.

ARM lägger också ner stora resurser på att se vad som är möjligt i framtiden. Neuronnät och superparallella konstruktioner gör det möjligt att öka prestanda i förhållande till energiförbrukningen ganska dramatiskt. Dagens modernaste processorer innebär enligt Muller på en effekt på ca 75 W för att driva en miljon "neuroner". Om vi jämför med människohjärnan krävs bara ca 20 W för att driva 100 miljarder neuroner. Så det är långt kvar.

Nyckeln till det hela är förstås att både minska effektförbrukningen för att utföra en uppgift och se till att bara de enheter som faktiskt har något produktivt att göra faktiskt är igång. Här utvecklas verktyg och metoder mycket snabbt.

Sedan kan man kanske tycka att Mullers ”PCn är inte död – bara irrelevant” är ett ganska riskabelt uttalande. Tala om att sticka ut hakan.

Bygger kapacitet

EDA-industrin och halvledarindustrin går ganska hyfsat just nu och det byggs massor av tillverkningskapacitet för 28 nm. Det blir alltså lönsamt att konstruera och konstruera om i 28 nm och mindre. De närmaste åren kommer därför EDA-företagen att ha mycket att göra och det kommer att finnas gott om konstruktörsjobb.

Det byggs massor av tillverkningskapacitet för 28 nm. De närmaste åren kommer, enligt Wally Rhines, CEO för Mentor Graphics, därför EDA-företagen att ha mycket att göra.

Sedan får vi väl se vad som händer i en situation med överproduktion både på de allra nyaste teknologierna och dagens 45 nm-processer. Speciellt som vi inte ser samma kapacitetsutbyggnad på minnessidan. Här var som vanligt Mentor-chefen Wally Rhines en suverän informationskälla, även om jag och många andra blev lite skrämda av de inhyrda jonglörernas hårdhänta behandling av Rhines på Mentors årliga DAC-fest. Det såg faktiskt ut som om han fick ett bowlingklot i huvudet och sådant kan ju försämra den analytiska kapaciteten hos den bäste.

Plattformar

Det var alltså en bra DAC, även om mediauppbådet från Europa var minst sagt svagt (inte mig emot i och för sig). Ändå är det väl bara att konstatera att marknaden för halvledarkonstruktion och konstruktionsverktyg kommer allt längre från ”gemene man”. Allt blir mycket mer avancerat och allt intressantare, samtidigt som de flesta nöjer sig med vad som händer på plattformsnivån och uppåt (t ex embedded). Det är synd, eftersom risken då blir stor att man missar viktiga trender och teknikskiften.

Men idag är i alla fall ARM-trenden närmast löjligt stark. ARM finns nästan överallt och det är lätt att dra slutsatsen att framtiden tillhör ARM och ARM allena. Men sådana slutsatser bör man nog akta sig för. ARM-trenden kommer säkert att fortsätta så länge ARM levererar bästa prestanda i förhållande till energiförbrukningen.

Plattformar baserade på ARM finns överallt, men Intel håller också ställningarna.

I det ögonblick som någon annan tillverkare kan visa dramatiskt bättre prestanda i förhållande till energiförbrukningen kan mycket väl allt förändras. Visst krävs det gigantiska insatser för att skapa en fungerande mjukvaruplattform, men om vinsten är stor nog blir det också intressant att "börja om från början".

Heterogena system

Lite av det här ser vi i det ökade intresset för heterogena system. Idag innebär det här några ARM-kärnor (eller x86-kärnor) plus grafikkärnor och eventuellt kryptokärnor. Allt kopplas samman med extremt snabb kommunikation på ett enda chip (eller med stackade chip).

Men det går att göra så mycket mer på det här sättet, med acceleratorer för allt som är komplicerat. Det är förstås grymt svårt att göra mjukvara som fullt ut drar nytta av det här, men de möjliga vinsterna i prestanda och energiförbrukning är mycket stora. På sikt kan därför kriget mellan ARM och x86 bli tämligen irrelevant.

Farligt att vara tvärsäker

Den som väljer att bortse från EDA- och SoC-industrin för att "plattformen är ändå standardiserad" riskerar alltså att få en obehaglig överraskning. Visst kan man hävda att allt som DAC står för bara angår specialister och "nördar", men det räcker med ett teknikskifte för att DAC plötsligt skall bli fruktansvärt viktigt igen.

För, trots allt är det som diskuteras på DAC basen för nästan allt i vårt moderna samhälle. Under de 49 år som DAC har funnits (nästa år är 50-årsjubileum) har vi sett en rad stora systemskiften och alla de som varit "tvärsäkra" har lämnats i diket.

Så jag tänker nog fortsätta att bevaka DAC.

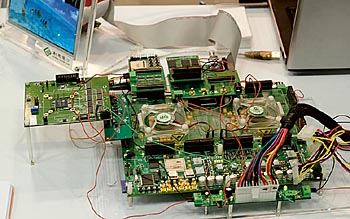

Stora konstruktioner måste kunna verifieras snabbt. Så här ser en typisk "ASIC-emulator" ut idag, med ett par jätte-FPGAer (här Xilinx Virtex 7). Kinesiska S2C kommer nästa år att ha system med upp till nio kretsar och 180 miljoner grindar.

Gary Smith är en av de få som varit med på alla 49 DAC-konferenserna och han gjorde sin traditionsenliga analys av EDA-marknaden.

Apache Design är ett av de företag som satsar hårt på energioptimering. Företaget ägs numera av Ansys och Andrew T Yang är chef för den fristående divisionen Apache Design.

Trots alla nya verktyg lever fortfarande SPICE-simulatorn i högönsklig välmåga. Simon Young från Berkley Design Automation säger sig ha den snabbaste simulatorn.

Xlinx har satsat mycket hårt på egna utvecklingsverktyg, men också på samarbete med andra EDA-företag. Tom Feist är ansvarig för marknadsföring av utvecklingsmetoder och tror på system som är "all programmable".

Uppstartsföretaget Excellicom startade för två år sedan och arbetar med timinganalys. Fia Johansson är marknadsföringsansvarig.

Verifiering med FPGA-baserade prototypkort är större än någonsin, men Lars-Eric Lundgren ägnar sig numera åt att finansiera nya företag. Det verifieringssystem hans företag byggde för ett antal år sedan finns numera hos Synopsys.

Det gäller att samarbeta och många EDA-företag samlas under "paraplyn" som t ex halvledartillverkaren Global Foundries.

Ett av keynoteföredragen hölls av Intels Brad Heaney och hade rubriken "Designing a 22 nm Intel Architecture".

Filed under: Embedded